Jak jednoduše na lokálně akcelerovanou AI. Ukážeme, co umí i jak ji zprovoznit | Kapitola 4

Seznam kapitol

Používání lokálně akcelerované AI je snadné a přináší výhody jako lepší soukromí a nezávislost na cloudu. Jak AI rozjet a co umí?

Nyní se dostáváme k trošku méně uživatelky příjemnějším rozhraním, ale v tomto případě se to vyvažuje větším počtem stáhnutelných modelů. Zejména je zde přístup k modelům s opravdu vysokým počtem parametrů.

Funkční framework stáhnete ze stránek Ollamy, program nainstalujete a následně se nic nestane. Ollama totiž nemá žádné uživatelské prostředí a indikací správné instalace je ikona na pravé straně spodní lišty ve Windows.

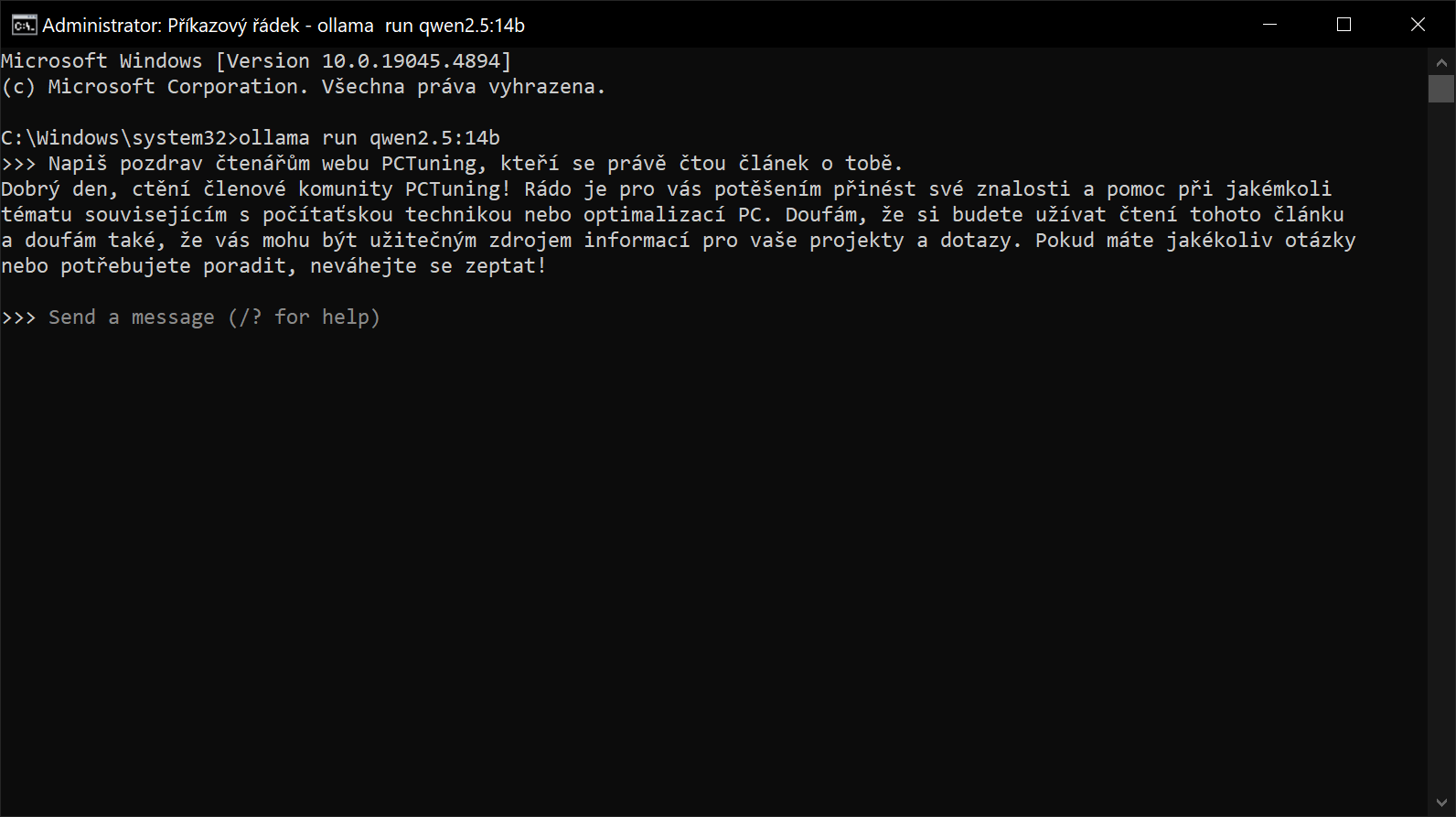

K aplikace se přistupuje skrze příkazový řádek. Například můžete čistě stáhnout model s příkazem jako „ollama pull llama3.1:8b“ a následně můžete model spustit příkazem „ollama run llama3.1:8b“. Stále však budete pokračovat v příkazovém řádku, kde si s modely budete chatovat.

Z principu příkazového řádku zde nemůže komunikace probíhat hlasově a k dispozici nejsou ani pokročilá nastavení nebo možnost nahrávat soubory. Velmi pokročilí uživatelé však mohou použít například nadstavbu Open Web UI, která to umožňuje, ale její instalace a nastavení je složité.

Ollama vyniká v jedné věci, a to je počet dostupných modelů. Pokud chcete opravdu pokročilý chatovací model a potřebujete jej nainstalovat jednoduše, Ollama to zvládne. Stačí na to v podstatě jediný příkaz v příkazovém řádku (příkaz „run“ model i stáhne, pokud již není v počítači). K dispozici je navíc obrovský počet modelů od různých vývojářů, také zde naleznete starší modely, pokud byste z nějakého důvodu chtěli otestovat dřívější verzi.

Zde jsem testoval modely llama3.1 (8B), qwen2.5 (14B) a Mistral-small (22B), abych si ověřil, zdali se s počtem parametrů zlepšuje i porozumění a psaní textu. A to se v praxi také ukázalo, modely s vyšším počtem parametrů lépe chápou zadání a také velmi solidně zvládají češtinu, takže rozdíly mezi nimi uvidíte i v praxi.

Konkrétní rozdíly jsou důslednější argumentace a model také lépe sleduje argumentační linku a nezapomíná na některé pasáže ze zadání. Komplexnější modely při používání v češtině si už tolik nevymýšlí slova a nepoužívají anglické výrazy, případně vůbec nesklouznou k použití angličtiny namísto češtiny.

Pokud máte dostatečně výkonný počítač, otevírají se vám pokročilejší možnosti. Můžete nejen stahovat lepší modely a provádět na nich složitější činnosti, ale také bych doporučil vyzkoušet i pokročilejší prostředí jako zmíněné Open Web UI nebo instalovat AI modely napřímo. V takových situacích umí být umělá inteligence velmi nápomocná.