Nvidia a ARM: Jaký to dává smysl? | Kapitola 4

Seznam kapitol

ARM je designérská společnost, která navrhuje architektury procesorů. Nvidia dělá své procesory a GPU. Jaké dává jejich spojená smysl? Proč je Nvidia ochotná za ARM zaplatit 40 miliard amerických dolarů? Znamená to konec ARMu tak, jak jej známe? O co se hraje a na čem ještě může celý obchod ztroskotat?

V minulosti jsme viděli už několik pozoruhodných pokusů o překročení hranice mezi GPU a CPU. Za asi nejzajímavější považuji projekt Larabee od Intelu z roku 2009, kde se Intel pokusil vytvořit grafickou kartu, založenou na architektuře x86. Konkrétně – na masivním poli 32 procesorů založených na jádře P54C. Teorie vypadala tak, že pomocí softwaru budete moci simulovat hardware přesně tak, jak chcete – a vlastně si tak můžete udělat grafiku softwarově na míru.

Larabee vznik v několika iteracích, ta novější se dostala do rukou Linuse – a přestože pro ni nesehnal ovladače a nic to nedělalo, je stejně zajímavé podívat se na tento projekt. Podle Linuse se projektu Larabee stalo osudným to, že si management Intelu chtěl vybrat mezi klasickými IGP a Larabee, i když je víceméně jasné, že jde o velmi odlišné koncepty.

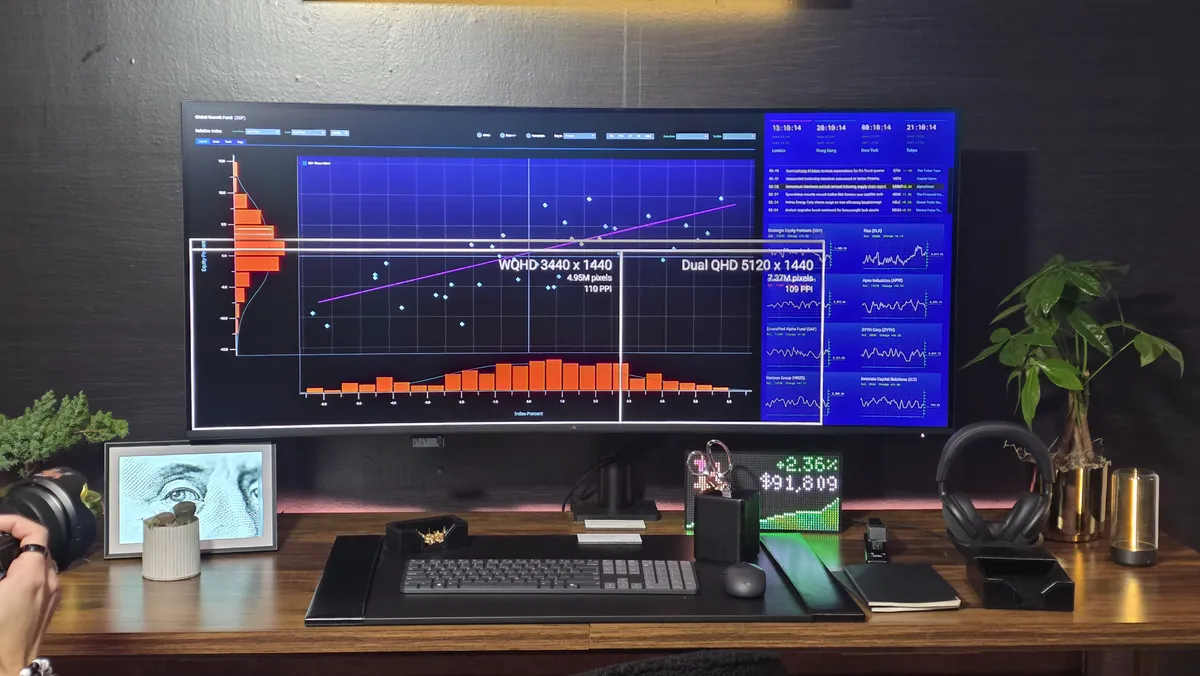

Zatímco dřív se experimentovalo s nahrazením specializovaného GPU polem klasických procesorů, dnes pozorujeme u GPGPU technologií opak. Moderní GPU obsahuje velké množství poměrně volně programovatelných jader a lze je využít pro řešení obecných úloh, i když podle studií, které jsem četl, se ani zdaleka nehodí na všechno. GPGPU výpočty těží z rychlejších pamětí, ale úlohy se pro ně musí vhodně nastrukturovat, což s sebou nese penále. Jednotlivé elementy jsou navíc jednoduché, nemají rafinovanou architekturu s predikcí podmíněných skoků a poměrně špatně se jim pracuje s úlohami, které vyžadují hodně náhodných přístupů do paměti.

Pro úlohy, které jsou blízké zpracování obrazu, se ale hodí skvěle. Patří mezi ně i úlohy práce s obrazem a videem jako takovým a také úlohy rozeznávání, protože u nich jde o to také obraz opakovaně přechroupat. A zde máme jeden z možných motivů, o kterých se v souvislosti s fúzí mluví, totiž návrh specializovaných čipů pro AI, které shodou okolností jako mikrokontroléry využívají architektury ARM anebo RISC V.

Nvidia zřejmě sází na rozvoj umělé inteligence – a ta bude vyžadovat masivně paralelní procesory ve výkonné, ale i v úsporné verzi. Odpovídá to modelu jejich technologie DLSS: Na výkonných serverech se systém učí, na lokálních grafikách se výsledky učení aplikují. Jedna věc je umělou inteligenci trénovat – a věc jiná je ji rutinně spouštět. Kombinace zkušeností Nvidie s možností implementovat AI technologie do mobilních procesorů je zajímavá. Ostatně Nvidia experimentuje nejenom s DLSS, ale i s herním streamingem.