Betatest umělé inteligence na lidech běží naplno | Kapitola 2

Seznam kapitol

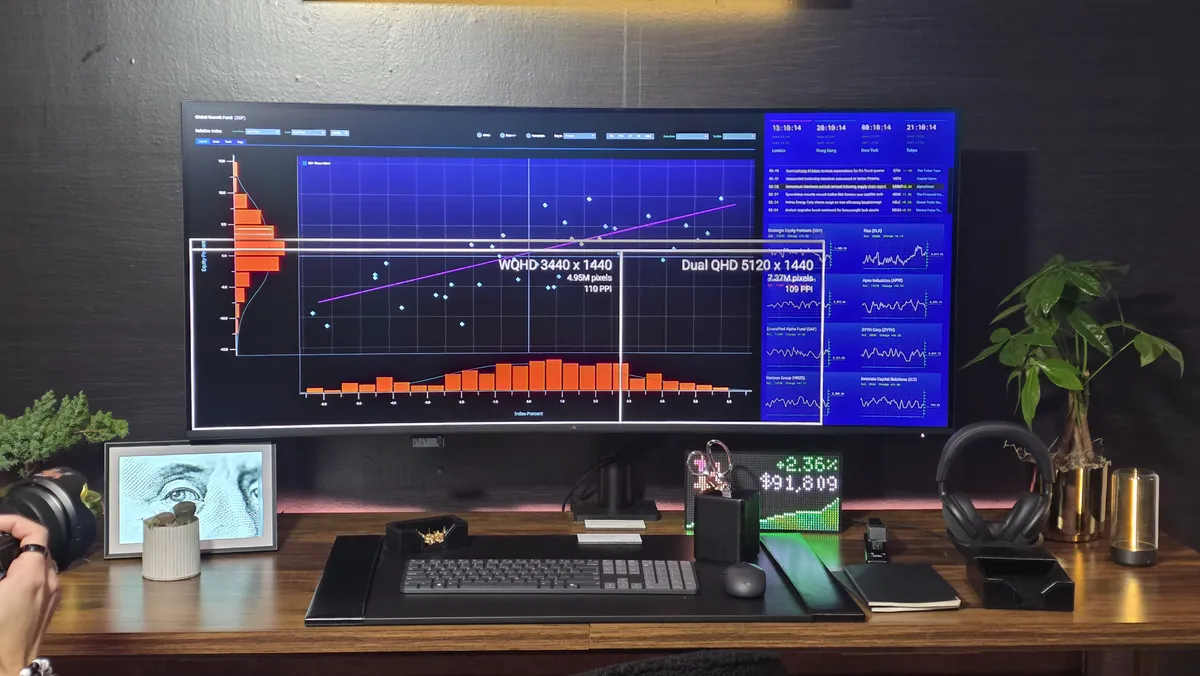

Ať už si o současné AI myslíte cokoliv, faktem zůstává, že jednou se populační betatest udělat musí. Nejde jen o to, jak ji lidé využívají, ale na co ji využívat chtějí. A to, že se pro betatest používá hlavně kecací a malovací AI, vlastně znamená, že na betatest jdeme od správného konce.

U konverzační umělé inteligence je největší riziko asi to, že ji hackeři použijí k tvorbě botnetů zaměřujících se na kreativní okrádání lidí věřících na nigerijské prince, kteří netuší, kam s penězi – anebo, jak ukázaly praktické experimenty, na manipulaci statistik tím, že „generujete veřejné mínění“, jak demonstroval Upper Echelon ve videu „The Company Destroying Hollywood“ o málo známé firmě Parrot Research.

Tato lidoměrná tlupa totiž používá k měření úspěšnosti filmů a pořadů svoji podivuhodnou metriku, která zahrnuje i „počty interakcí“, tedy tweety, příspěvky na sociálních sítích a podobně, což značně zkresluje představu o tom, jak populární jsou jednotlivé filmy a pořady. Kromě toho, že podle všeho Parrot Research nerozlišuje mezi pozitivními a negativními interakcemi, což by vysvětlovalo, proč jsou filmové propadáky označovány stále za úspěchy, je možné dost značně zkreslit jejich měření tím, že si vytvoříte botnet napojený na umělou inteligenci, který automaticky chválí určitý projekt, čímž v jejich měření činí tento projekt mnohem úspěšnějším.

Je-li tomu skutečně tak, tak Parrot Research možná vážně měří papoušky, kteří si s sebou navzájem povídají v klecích – anebo si v nich velmi brzy povídat budou, protože snahy o ohýbání doporučování videí a příspěvků jsme tu měli dávno před umělou inteligencí. To, že AI dá botům větší věrohodnost, je nasnadě – to se prostě stane.

Ale právě proto, abychom věděli, že se tohle vážně stane, musíme dělat veřejný betatest. Lidi jsou docela svině – a pokud veřejný betatest neuděláme, nebudeme vědět, v čem přesně a jak to zneužijí. Teprve když se objevily mikrotransakce, objevily se i herní prvky jako pay to win, výherní lootboxy a další věci, které jsme v minulosti prostě neměli. Jednoduché pravidlo říká, že pokud něco lze zneužít, tak to někdo zneužije, to se prostě stane. Víme to, ale jen někteří z nás mají imaginaci skutečně něco takového vymyslet a udělat to.

Právní teorie říká, že zákony by měly být jednoduché a snadno pochopitelné, přičemž efektivita prosazování zákona roste nikoliv s výší trestu, ale s pravděpodobností odhalení a rychlostí odsouzení. Každý efektivní právní systém se proto musí rozhodnout, co opravdu bude důsledně vymáhat – a protože čím více je nařízení, tím vyšší je počet přestupujících, jiná pravidla prosazuje jen sporadicky. Důležité je ale vědět co je opravdu to zásadní a co doopravdy hlídat.

Je celkem jasné, že ten, kdo vás kvůli penězům zabije, je horší než ten, kdo vás jen existenčně zničí, ten sám je horší než ten, kdo vás jen osobně obere a ten je opět horší než ten, kdo vás podfoukne na internetu – anebo vám jen ukradne něco, co je relativně snadno nahraditelné, například nelegálně používá vaši muziku u svých videí. Zločiny a přečiny mají svoji hierarchii podle společenské nebezpečnosti – a u umělé inteligence je dobré zjistit experimentálně, jak si na tom stojí, jak často se pravidla porušují. Tak například hacker, který na GPT-4 postaví chatbota, který z lidí tahá prachy, je určitě nebezpečnější než ten, kdo jenom obchází paywall OpenAI (což už se taky stalo).